生成AIガイドラインに欠かせないもの

第48回:IT後進国から脱却できるのか(8)

多田 芳昭

一部上場企業でセキュリティー事業に従事、システム開発子会社代表、データ運用工場長職、セキュリティー管理本部長職、関連製造系調達部門長職を歴任し、2020年にLogINラボを設立しコンサル事業活動中。領域はDX、セキュリティー管理、個人情報管理、危機管理、バックオフィス運用管理、資材・設備調達改革、人材育成など広範囲。バイアスを排除した情報分析、戦略策定支援、人材開発支援が強み。

2023/09/28

再考・日本の危機管理-いま何が課題か

多田 芳昭

一部上場企業でセキュリティー事業に従事、システム開発子会社代表、データ運用工場長職、セキュリティー管理本部長職、関連製造系調達部門長職を歴任し、2020年にLogINラボを設立しコンサル事業活動中。領域はDX、セキュリティー管理、個人情報管理、危機管理、バックオフィス運用管理、資材・設備調達改革、人材育成など広範囲。バイアスを排除した情報分析、戦略策定支援、人材開発支援が強み。

ここまで本シリーズをお読みいただいている方であれば、AIとはどのようなもので、利活用できれば大変便利なツールであると同時に、使い方を誤れば種々のリスクが発生することはご理解いただいているだろう。

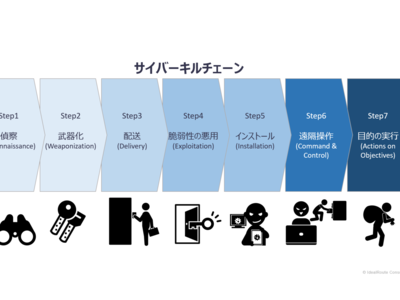

そのリスクは、ITすべてに共通のものもあれば、AI特有のものもある。巷で策定が必要だと言われるガイドラインは、AI特有のリスクという観点で定められたものであり、AIの特性を理解していれば、当たり前の内容が記述されているに過ぎないとお気付きであろう。

しかし、当たり前のことが書かれてあるガイドラインなのだが、問題もある。理由は言うまでもないだろうが、ガイドラインとして文字化し定義した瞬間に、その抜け道を通るなど、本来の趣旨と反する行為が発生するリスクも生じるのが世の常であるからだ。

法律であれば、法の抜け道を通る行為は違法性がないとされ、その時点では許容されるだろう。だが、ガイドラインのように法的縛りがなく設定されるルールの場合は事情が異なる。たとえガイドラインに書いてあるままに忠実に運用したとしても、その目的を違えて問題が生じるのであれば、それは不正と言われても仕方がない。結果がすべてなのである。

問題発生の原因は、ガイドライン策定時の記述不足かもしれないし、運用想定の不足かもしれない。ガイドライン通りの運用であったとしても、問題発生時には何の言い訳にもならないということは理解しておく必要がある。

わかりやすい事例で説明しよう。例えば、自社製品の使用時の安全を確保するために、製造時の検査基準や耐久テスト基準などを設定し、確実にそれらを守って出荷されたとしても、市場で安全性の問題が発生すれば責任は逃れられない。その場合、自社検査はクリアしているから問題ないと説明しようものなら炎上は必須であろう。

当然そこには、予期せぬ使用方法や環境の問題もあるだろう。だが、あらかじめその想定がなされ、禁止事項としていない限り、自社検査基準自体の誤りであり、リスク想定が甘いと判断される。

つまり、ガイドラインの例として提示されているのは、あくまで広く一般的に想定される策でしかなく、そのままで使えるわけではない。一般例として参考にしながらも、自社の運用内容、環境条件、関連業務との関係なども含めて、あくまで自社基準のリスク想定を行っていなければ意味はない。

そして、それらの自社条件は生モノであり、時間とともに変化するのも当然だ。定期的な見直し、確認作業は必須である。

再考・日本の危機管理-いま何が課題かの他の記事

おすすめ記事

リスク対策.PROライト会員用ダウンロードページ

リスク対策.PROライト会員はこちらのページから最新号をダウンロードできます。

2026/02/05

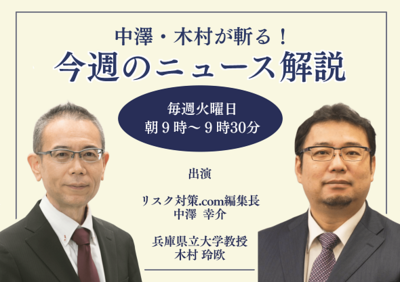

中澤・木村が斬る!今週のニュース解説

毎週火曜日(平日のみ)朝9時~、リスク対策.com編集長 中澤幸介と兵庫県立大学教授 木村玲欧氏(心理学・危機管理学)が今週注目のニュースを短く、わかりやすく解説します。

2026/02/03

発災後をリアルに想定した大規模訓練に学ぶ

2026年1月14日、横浜市庁舎10階の災害対策本部運営室で、九都県市合同による大規模な図上訓練が行われた。市職員に加え、警察、自衛隊、海上保安庁、医療従事者、ライフライン事業者などが一堂に会し、市災害対策本部運営をシミュレーションした。

2026/01/26

報告すべきか迷う情報 × 最初の一言 × 隠蔽と正直の分岐点

ここ数年、データ改ざんによる不正が突然発覚するケースが増えています。製品仕様に適合していないにもかかわらず、データの書き換えが行われていたり、燃費データや排ガス成分濃度が改ざんされているなど、さまざまな分野でこうした事件は後を絶ちません。今年も、中部電力・浜岡原子力発電所において、安全データの改ざん疑いが発覚しました。 こうした改ざんを未然に防ぐことは、リスクマネジメントの最重要テーマですが、一方で、既に起きてしまっていることを前提として、いかに早く発見し、対処するかを考えておくことも危機管理においては重要になります。

2026/01/26

※スパム投稿防止のためコメントは編集部の承認制となっておりますが、いただいたコメントは原則、すべて掲載いたします。

※個人情報は入力しないようご注意ください。

» パスワードをお忘れの方